在數字化浪潮的推動下,分布式系統已成為支撐現代互聯網服務、大數據分析與人工智能應用的核心架構。其演進歷程,特別是數據處理服務的演進,深刻反映了技術與業務需求的雙重驅動。本文將梳理這一演進流程,展現數據處理服務如何從簡單走向復雜,從集中邁向智能。

第一階段:單體集中式與數據孤島

在早期,系統通常是單體架構。數據處理服務內嵌于單一應用中,直接讀寫單一數據庫。數據存儲、計算邏輯和業務表現層緊密耦合。這種模式的優點是簡單、易于開發和部署。隨著數據量和業務復雜度的增長,其弊端凸顯:性能瓶頸難以突破,任何模塊的修改都可能影響全局,系統擴展性極差。數據被禁錮在特定的應用內,形成“數據孤島”,無法實現跨業務的整合與價值挖掘。

第二階段:垂直拆分與數據庫分離

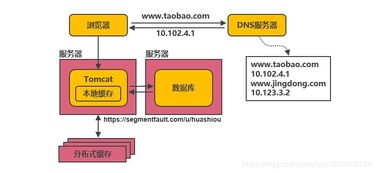

為應對單體架構的挑戰,系統演進的第一步是“垂直拆分”(或稱為“煙囪式架構”)。根據業務功能將大系統拆分為多個獨立的子系統,如用戶服務、訂單服務、商品服務等。每個子系統擁有自己獨立的數據庫,實現了技術棧和團隊職責的分離。數據處理開始按業務域進行劃分。此時的數據庫仍是集中式的(如主從復制),跨服務的復雜查詢和事務處理變得異常困難,數據一致性面臨挑戰。

第三階段:服務化與分布式數據庫興起

隨著微服務架構理念的普及,系統進入全面的“服務化”階段。每個微服務都是獨立部署、運行和演進的進程,通過輕量級協議(如HTTP/REST、gRPC)進行通信。這對數據處理服務提出了更高要求:

- 數據庫按服務拆分:每個微服務擁有其私有的數據庫,實現徹底的解耦。

- 分布式事務需求:跨多個服務的業務操作需要分布式事務解決方案,如Saga模式、TCC(Try-Confirm-Cancel)或基于消息隊列的最終一致性。

- 分布式數據庫登場:為滿足海量數據存儲、高并發訪問和高可用性,NewSQL(如TiDB、CockroachDB)和云原生分布式數據庫(如AWS Aurora、Google Spanner)開始廣泛應用,它們在提供橫向擴展能力的盡可能保持了SQL和ACID事務特性。

此階段,數據處理的核心矛盾是“分散的數據存儲”與“全局的數據視圖/分析需求”之間的沖突。

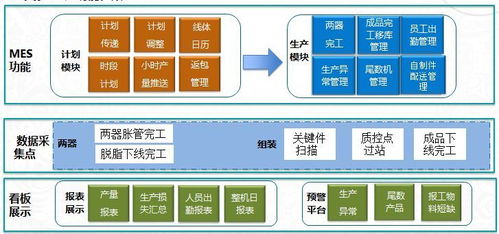

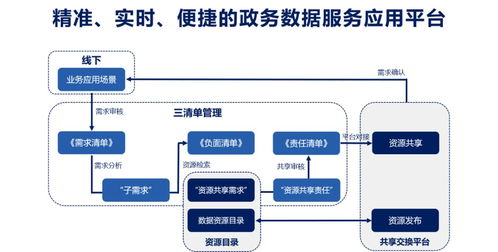

第四階段:數據中臺與流批一體處理

為解決數據分散問題,并最大化數據價值,“數據中臺”概念應運而生。它并非一個具體技術,而是一種組織架構和戰略,旨在構建統一、可復用、標準化的數據能力平臺。在技術層面,這催生了新一代數據處理服務模式:

- 中心化數據倉庫與數據湖:通過ETL/ELT流程,將各業務系統的數據匯聚到統一的數據倉庫(如Snowflake、BigQuery)或數據湖(如基于HDFS、S3的存儲)中,形成企業級單一事實來源。

- 流批一體處理框架:傳統Lambda架構(批處理和流處理兩套系統)的運維復雜度高。以Apache Flink為代表的流批一體引擎,實現了用同一套API和運行時處理實時流數據和歷史批量數據,極大地簡化了架構。數據處理服務從“T+1”的離線報表,邁向實時監控、實時推薦和實時風控。

- 數據服務化:將清洗、整合后的數據,通過API的方式透明、安全地提供給前臺業務應用,使數據消費像調用普通服務一樣簡單。

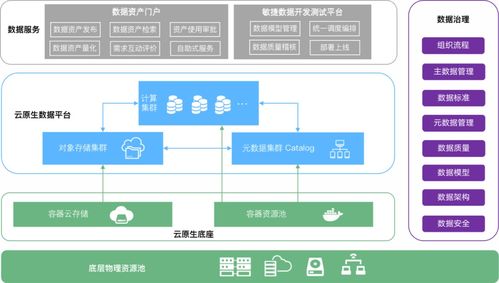

第五階段:云原生、智能化與無服務器化

當前,分布式數據處理服務正全面擁抱云原生和智能化。

- 云原生數據服務:利用容器化(Docker)、編排(Kubernetes)、服務網格(Istio)和聲明式API,實現數據處理服務的彈性伸縮、故障自愈和高效運維。存儲計算分離架構成為主流,使得兩者可以獨立擴展。

- Serverless數據處理:用戶無需關心服務器基礎設施,只需關注業務邏輯和數據。云廠商提供的Serverless化服務,如AWS Glue(ETL)、Azure Functions(事件驅動計算)、Google BigQuery(數倉),實現了極致的彈性與成本優化,按使用量付費。

- AI驅動的智能數據管理:機器學習被深度融入數據處理全鏈路。包括:智能數據分級與治理、自動化的數據質量檢測與修復、基于查詢歷史的自動性能優化(如自動索引、物化視圖)、以及智能的元數據管理與數據發現工具。數據處理服務本身變得更加“聰明”和自動化。

演進的核心驅動力與未來展望

縱觀演進流程,驅動力始終是規模(Scale)、復雜度(Complexity) 和速度(Speed)。從處理GB級數據到PB/EB級數據,從結構化數據到多模態數據,從離線分析到實時智能決策,每一次架構演進都是為了在新的挑戰下重新找到簡單、可靠與效率的平衡點。

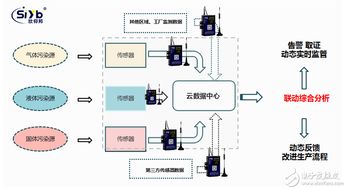

隨著邊緣計算的普及和物聯網數據的爆發,分布式數據處理將進一步向“云-邊-端”協同演進。數據隱私與安全(如聯邦學習、差分隱私)、綠色計算(降低數據處理能耗)也將成為演進的重要維度。數據處理服務將更深地隱藏于底層,作為智能時代無處不在的水和電,為上層應用提供源源不斷的數據動能。